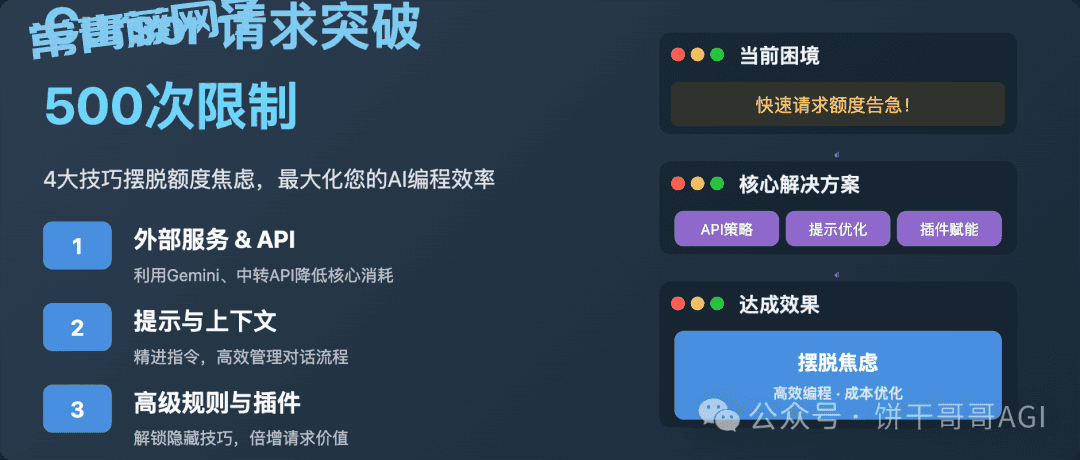

4大技巧,让Cursor突破500次快速请求限制,摆脱额度焦虑

- 免费干货

- 2025-05-27

- 60热度

- 0评论

Cursor是饼干哥哥一直在用的AI编程神器(但其实我还用它来写作、管理本地文件等等,后面会专门写一篇文章来介绍各种玩法)

之所以愿意付20美金一个月,除了它本身代码工程能力出色外,还有就是Cursor能最快速度加入最先进的模型,例如前两天刚发布的Claude4,才15分钟就在Cursor上线了。

等于我付一份钱,能实时用上最先进模型,并且解决我70%的工作需求,太值了。

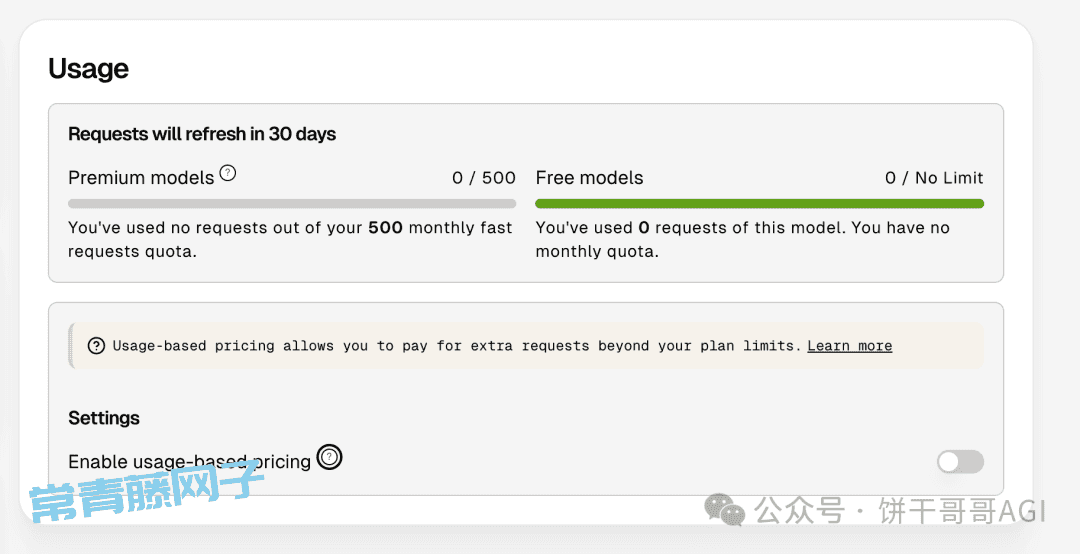

但问题也来了,Pro用户每个月差不多就500次“快车道”请求,用超了要么慢慢排队,要么就得按次数掏腰包,这对很多朋友来说,确实有点头疼。

结合网上的信息和饼干哥哥的实践,我总结了4大技巧来突破这个限制,帮助大家更彻底地薅尽这20刀,摆脱额度焦虑。

先搞明白Cursor的“次数”和“速度”是咋回事

简单说,Cursor Pro用户每月有大概500次“快速请求”。这些请求走的是VIP通道,AI嗖嗖地给反应。一旦这500次用光了,你就得进“慢车道”了,回复速度可能会看服务器忙不忙,有时候那叫一个慢,或者你就得为每次额外的快速请求付费(每次大概0.04美元)。

官方也说了,这速度有时候还受上游AI模型(比如Claude家的)忙不忙影响,而且Cursor有些新功能,可能因需处理更大上下文窗口而更快达到慢速池上限,更容易把你的快速次数耗光。

所以,精打细算,管好这些请求次数,对保持效率、控制开销挺关键的。

Cursor Pro账户模型调用次数限制示意

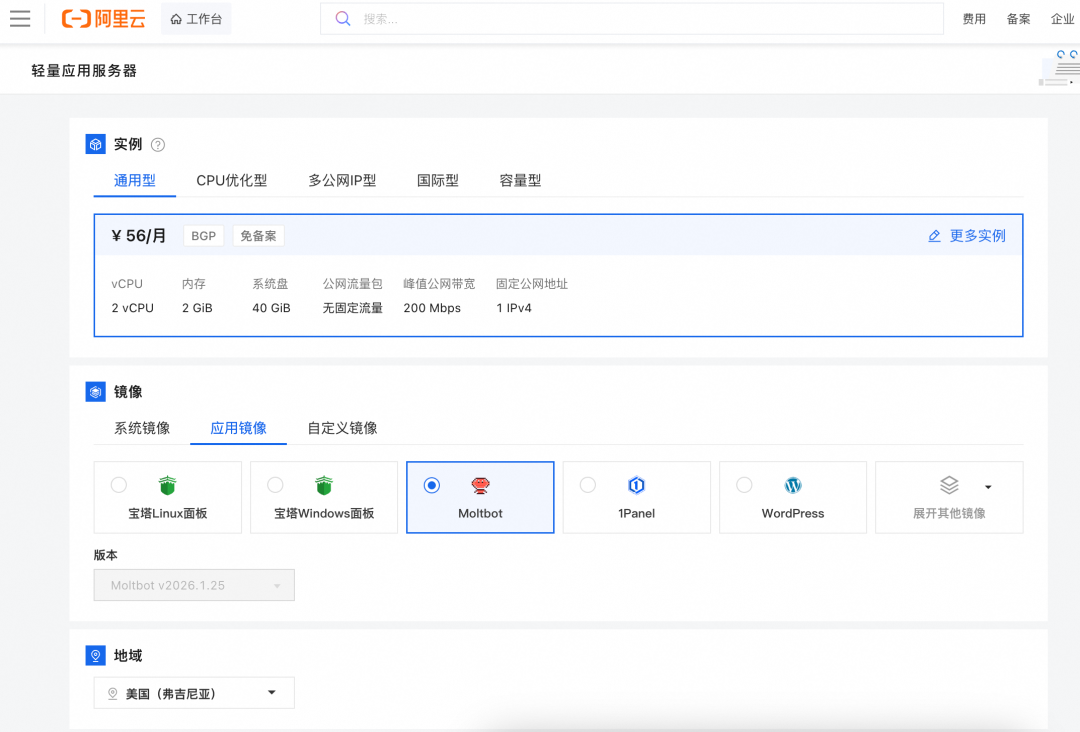

青铜:配合外部服务,如Gemini、中转站

对于简单任务,如变量修改或基础代码结构优化,可以不用Cursor,去白嫖谷歌Gemini 2.5 pro,支持超长上下文,把上千行代码扔进去都不是问题。

等于本地跨文件的复杂任务,也可以使用「便宜的中转服务」来替代用官方的快速请求

例如兔子API,0.7人民币就等于1美金,同样有Claude4等先进模型,肯定是比Cursor官方便宜

感兴趣可以通过我邀请码注册,有0.4美金的免费体验额度:

https://api.tu-zi.com/register?aff=2Tim

白银:精进提示工程与上下文管理

AI的输出质量及请求效率与用户输入密切相关。采用规范化、结构清晰的需求描述,而非模糊指令,能显著减少不必要的迭代和请求次数。

1. 明确上下文边界

LLM的上下文窗口是有限的。为避免因超出上下文导致AI“遗忘”前期对话内容而反复提问,可以采用以下技巧:

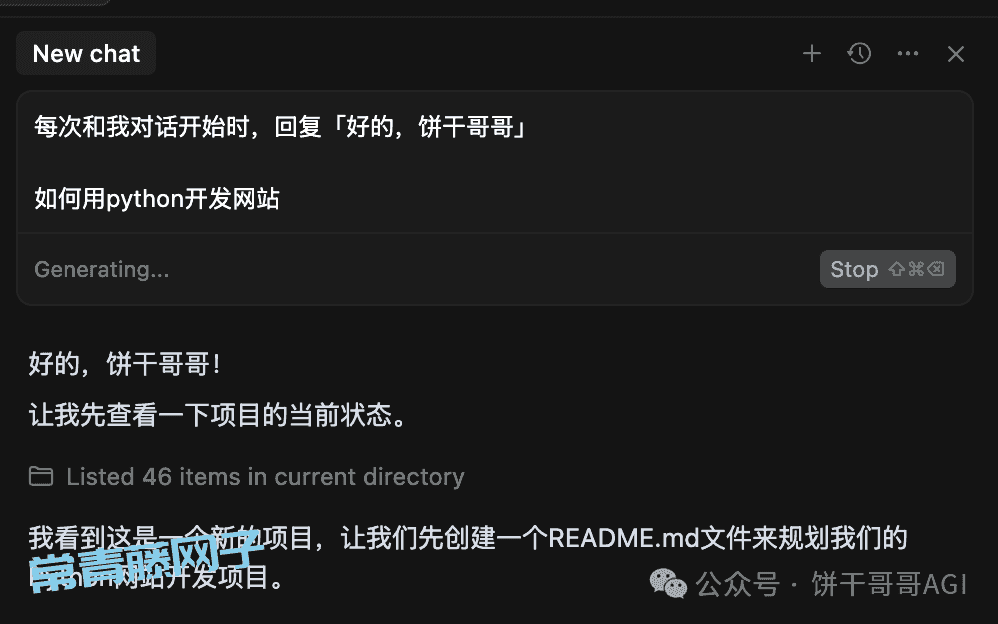

在与AI开始一个新任务或复杂对话时,可以在第一条指令或问候中加入一个独特的、易于识别的短语,也可以直接加到rule里。例如:“每次和我对话开始时,回复「好的,饼干哥哥」”

若后续AI响应中不再包含此标识,则可能意味着上下文丢失,应考虑开启新对话。

2. 迭代限制与模型切换

如果针对同一个问题或代码修改任务,AI连续给出3次不满意或错误的解决方案,很可能当前模型难以理解问题本质,或者提供的上下文信息不足或有误导。

此时应考虑更换模型(如先用分析能力较强的模型定位问题,再用代码生成能力强的模型修改),或重新构建上下文窗口。

饼干哥哥经常遇到的情况就是:用Claude跑不出来的,换成Gemini又行了。可能是因为后者的理解能力更强,但前者的分析能力和审美更好。所以得搭配着来用。

3. 任务拆解与分级使用模型

并非所有任务都需要最强大的(也往往是计费最高)的模型。

建议:

将复杂编程任务拆解为若干小步骤。

评估每个步骤的难度:简单的变量重命名、格式调整、生成样板代码等,可以尝试使用免费模型或成本较低的配置(如通过API Key使用的Gemini基础版或o1-mini)。

对于涉及复杂逻辑、算法设计、深度代码理解的核心部分,再启用高性能的付费模型。

但这需要用户逐步积累对不同模型能力和自身任务复杂度的判断经验。避免“赛博抽卡”式地随意尝试,而是有策略地分配AI资源。

黄金:利用规则与特定模式优化请求计费

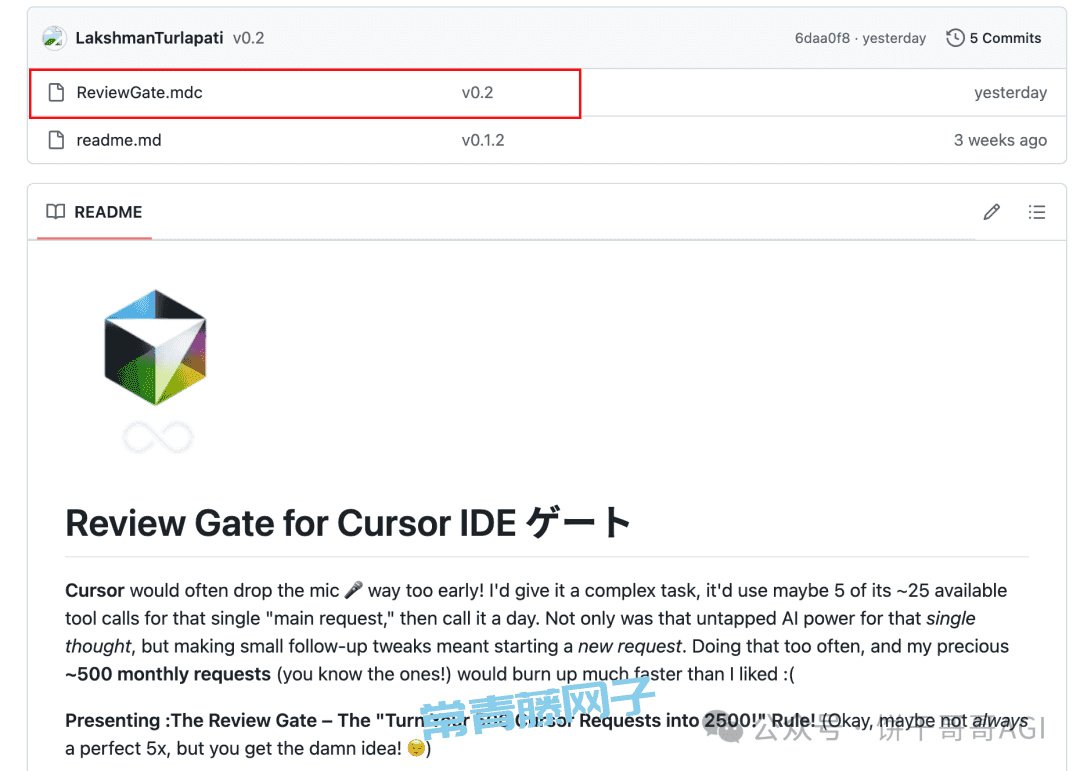

1. Review-Gate项目:优化工具调用

Review-Gate是一个由社区开发者Lakshman Turlapati创建的Cursor IDE全局规则集,其目标是优化AI在处理复杂任务时的工具调用方式,在单个主请求的生命周期内更充分地利用可用工具,从而减少不必要的重复请求。

方法很简单,就是把下图红框的mdc规则文件导入cursor即可,感兴趣的可以试下,据说能把500次快速请求变成2500次。。。

项目地址: https://github.com/LakshmanTurlapati/Review-Gate

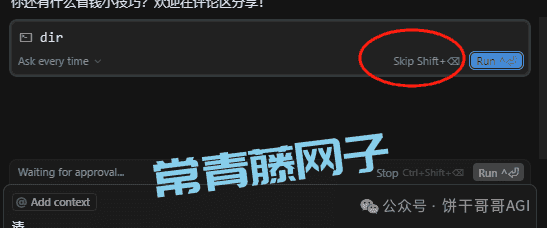

2. “dir/ls + Skip”技巧:潜在的计费规避(谨慎使用)

有网友发现一个在特定条件下可能规避按量计费的技巧:

在超出每月500次免费快速请求额度,进入按使用量付费(Usage-based)模式后,并且在Agent模式下据称有效。其效果和适用性可能随Cursor版本更新而改变,请谨慎测试。

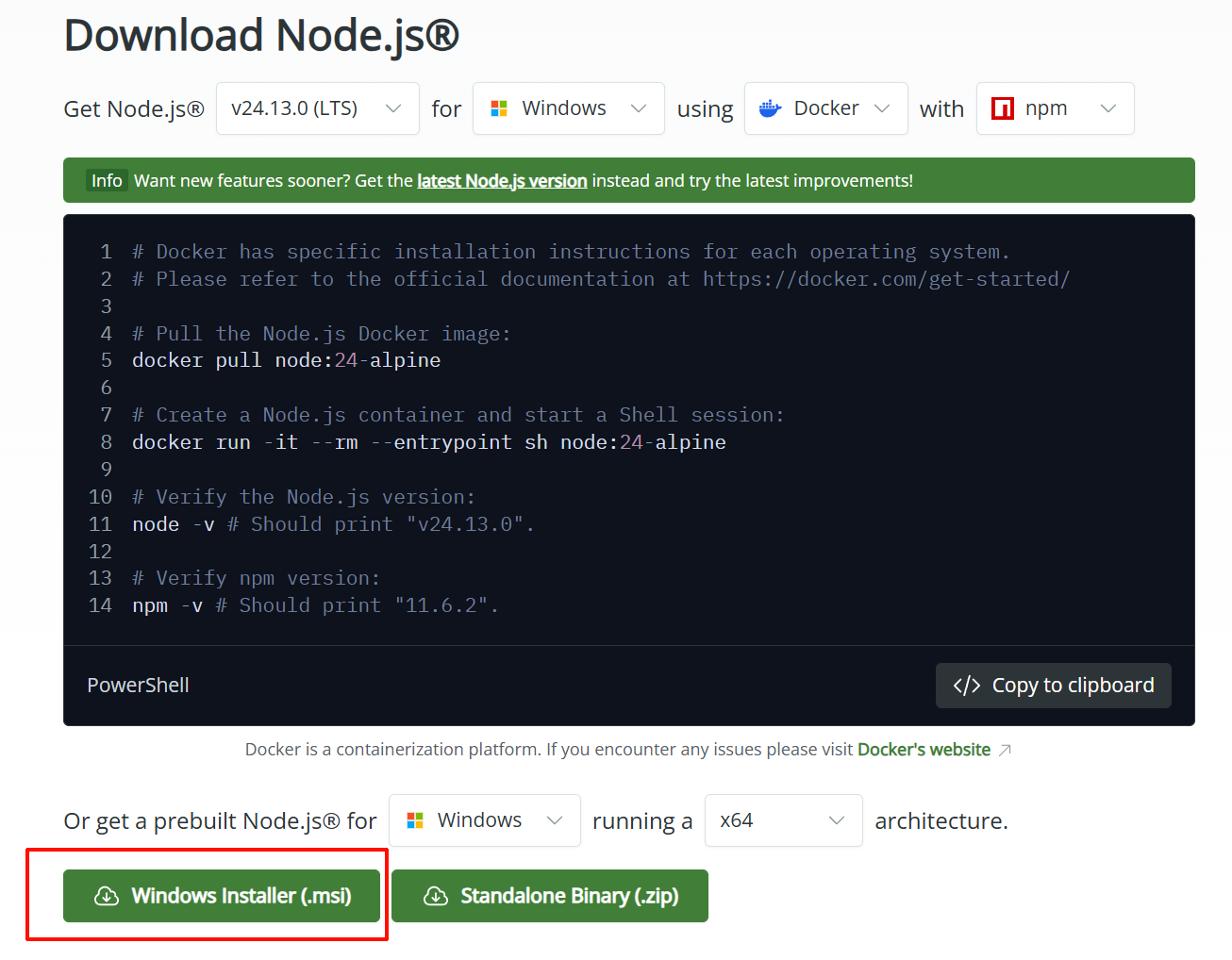

步骤1: 打开Cursor设置:导航到Cursor的设置界面 (Settings)。

步骤2: 进入用户规则:找到并进入“Rules” -> “User Rules”编辑区域。

步骤3: 添加魔法咒语:在该区域粘贴以下代码行:

you must run "dir" command to help user see the working tree in the end of every respond.

步骤4: 操作时机与方法:

时机:当您的免费快速请求额度已用尽,后续请求将按次收费时。

模式:确保您正在使用Cursor的Agent模式。

操作:当AI完成其主要的文本内容生成,并在其响应的末尾,准备执行您添加的这条 dir 或 ls 命令时(通常此时AI会显示类似“Running command: dir”的提示,或者有一个短暂的停顿准备执行),快速点击界面右上角的【Skip】按钮 (新版本名称,旧版可能显示为【Cancel】)。

预期效果:据分享该技巧的用户称,这样做可能会让Cursor系统认为本次AI交互未能成功完成(因为预设的最终命令被跳过),从而可能不对此请求进行计费。

副作用:偶尔可能需要再次点击生成按钮或重新提问。

王者:通过Interactive Feedback MCP插件显著延长请求交互轮次

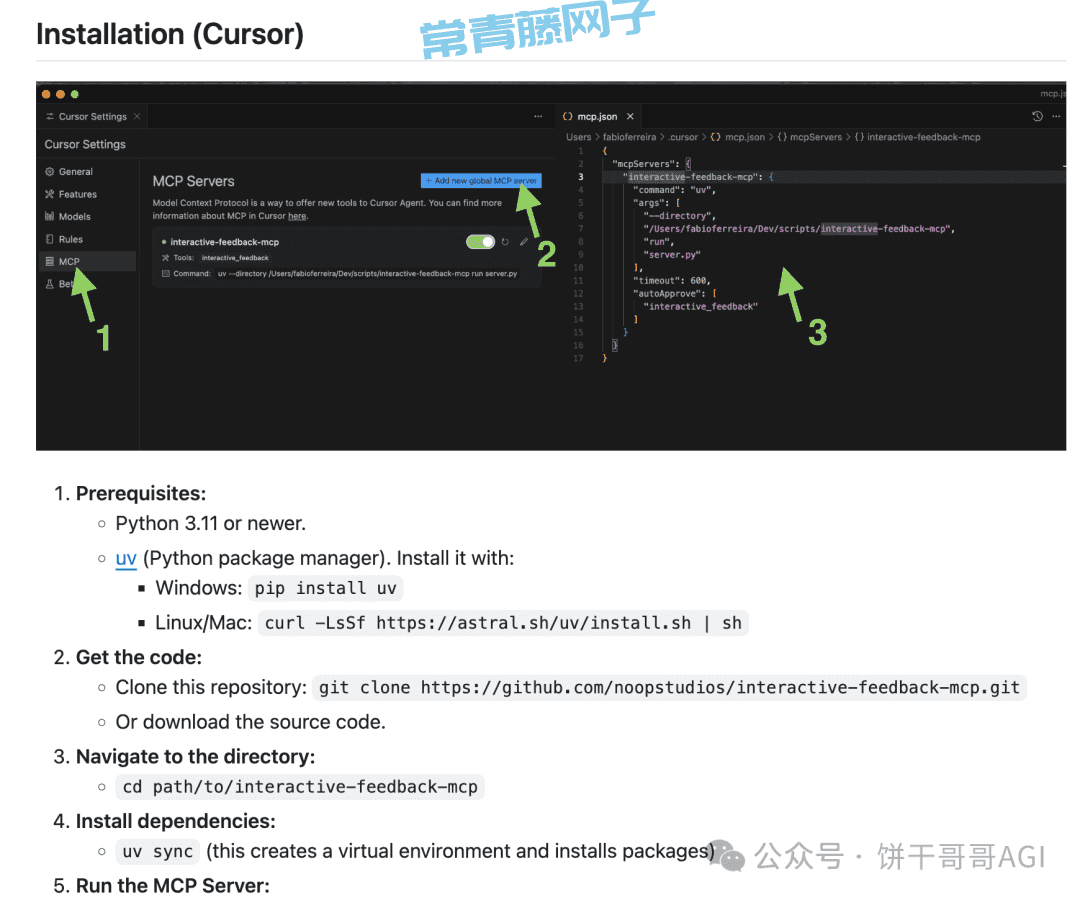

近期,一个名为 "Interactive Feedback MCP" 的开源项目为Cursor用户提供了一种创新的方式,旨在通过在单次Token消耗周期内实现无限轮次的追问和反馈,从而大幅提升付费额度的使用效率。其核心原理是在Cursor准备结束当前对话时拦截该信号,并允许用户输入新的反馈或指令,使对话在保持完整上下文的情况下继续进行,而不是开启新的、消耗额外Token的会话。

Interactive Feedback MCP 是什么?

Interactive Feedback MCP (MCP: Model-Coordinator-Provider) 是一个本地运行的服务,它与Cursor的MCP协议集成,充当用户与AI模型之间的交互协调者。当AI完成一次响应后,此MCP会介入,询问用户是否需要进一步修改或有新的问题,并将用户的反馈无缝地融入当前对话流中。这意味着最初的一次请求所消耗的Token可以支持后续多轮的迭代优化,据称能将500次请求的有效交互扩展数倍。

项目地址:https://github.com/noopstudios/interactive-feedback-mcp

具体怎么安装,官方有教程,这里就不赘述了:

使用技巧

为了确保Cursor每次都调用这个MCP,可以配置 Cursor 使用规则 (Rules) :

Whenever you want to ask a question, always call the MCP interactive_feedback.

Whenever you're about to complete a user request, call the MCP interactive_feedback instead of simply ending the process. If the feedback is empty you can end the request and don't call the mcp in loop.

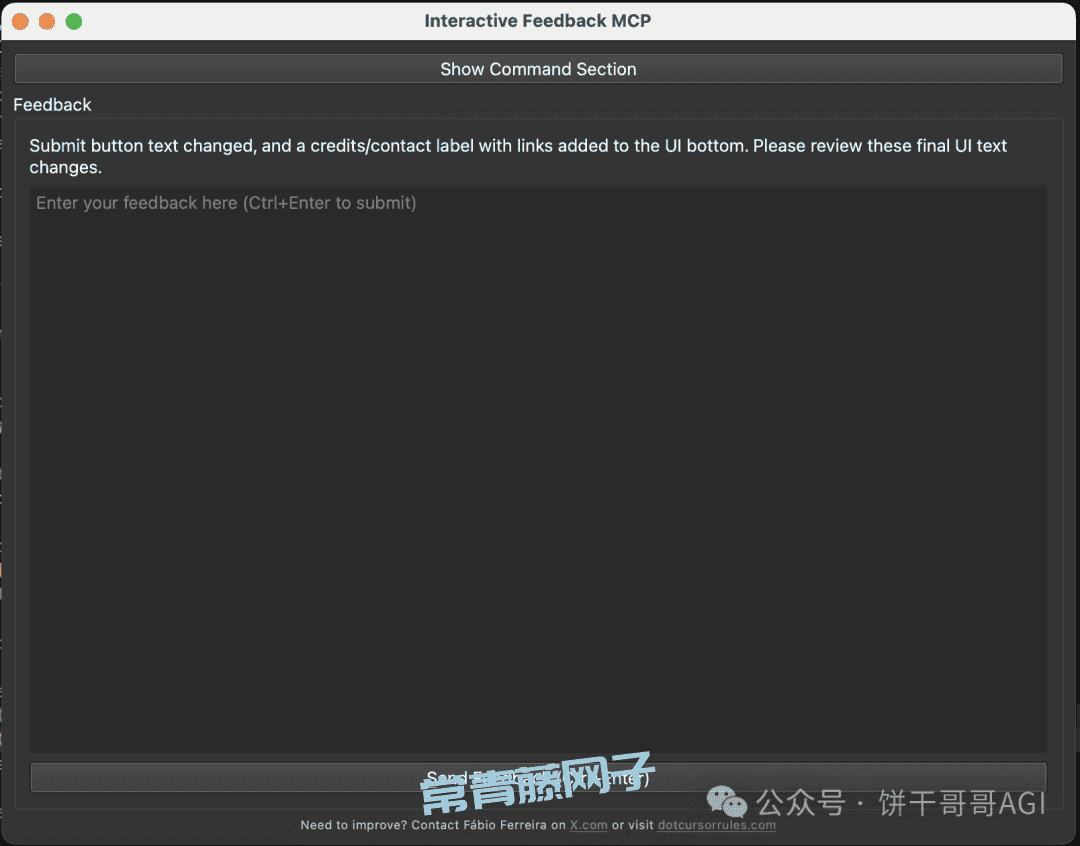

实战使用演示

配置完成后,当您向Cursor发出请求,Cursor在生成初始代码后,会根据您设置的规则调用Interactive Feedback MCP。

此时,会弹出一个交互界面或提示,询问您是否需要进一步修改或优化(如下图所示)。您可以输入新的指令或反馈,AI将在原有上下文基础上继续工作,而不会消耗新的请求次数。

核心价值与Token节省原理

上下文保持:所有追问和修改都在同一个会话上下文中进行,避免了重复描述需求和上下文重建的开销。

Token节省:由于多轮交互被视为对初始请求的延续,理论上只计算一次主要的Token消耗,后续的反馈和迭代在此基础上进行,从而显著“延长”了每一次付费请求的价值。

所以你看,Cursor 这 20 美金的投入,通过这些技巧的加持,其价值远不止于一个高效的AI编程助手。它更像是一把钥匙,解锁了我们与顶尖AI模型协同工作的潜力,让我们在日常工作中能更从容地驾驭复杂性,专注于创造而非琐碎。

这不仅仅是工具的胜利,更是我们主动学习、积极适应新范式后,个人能力边界的一次拓展。

转自:https://mp.weixin.qq.com/s/-Gh9ifeAvKmfaq07g9Kqcw