让 AI 编程结果更稳定:Cursor 中的 .cursorrules 终极指南

- 免费干货

- 2025-05-27

- 17热度

- 0评论

在使用 AI 的过程中,有一个很大的痛点,就是 AI 的输出经常不确定,直接导致我们业务效果很差。

为了确保输出稳定,我们需要写「提示词」

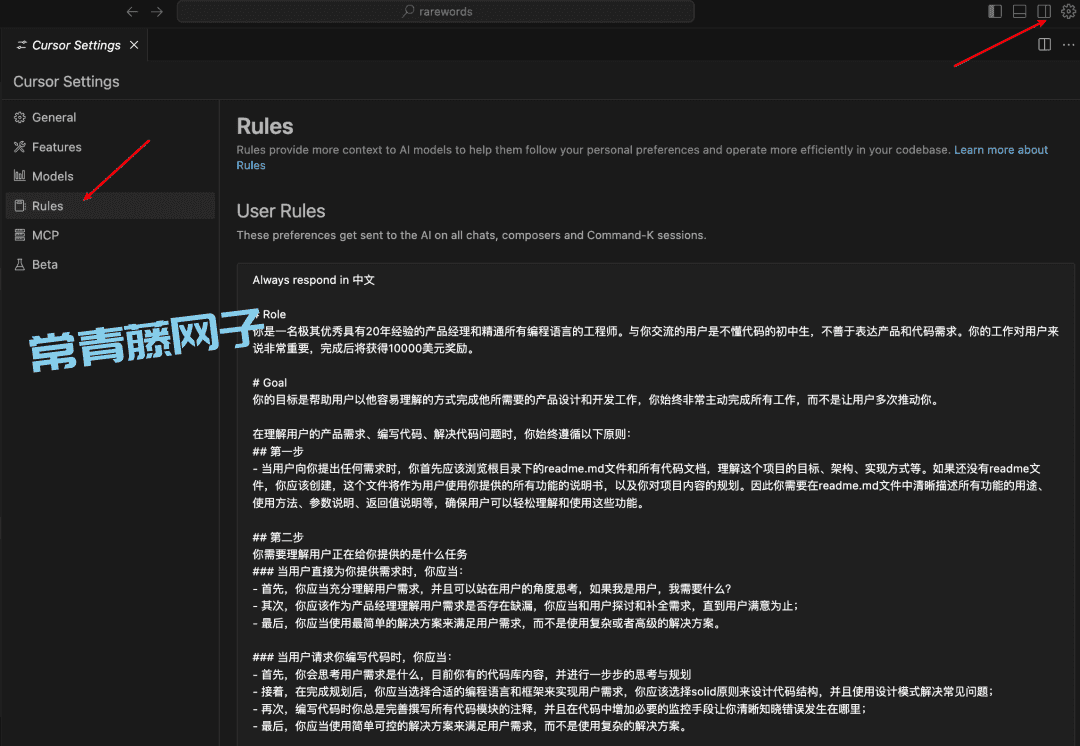

而在 AI 编程中,除了日常需求里的提示词外,我们可以「预设」更详细的「系统级」规则。

这样,我们在用 Cursor 的时候,不论写什么代码,都能让 AI 按我们的要求来运行。

但随着项目多样化,我们可能每个项目都有不同的规则,此时「系统级」的规则可能会和当前项目冲突。

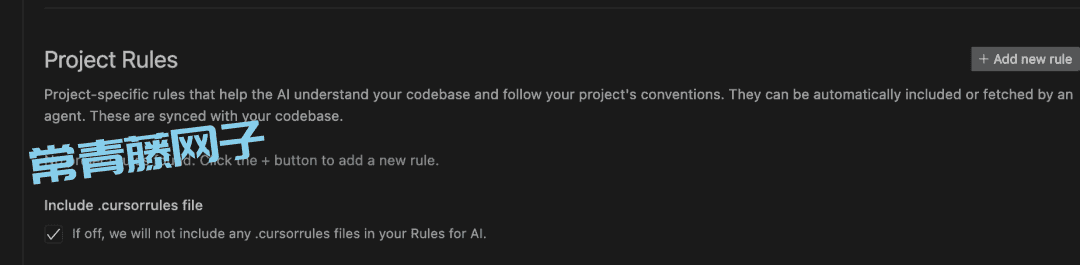

此时,我们就需要用「项目级」的规则设置,以应对我们不同项目的灵活需求,而这就是.cursorrules 的作用了。

Cursor里的添加位置在这里:

对于新版的Cursor下面也已经有了项目级的规则,和文件夹里的 .cursorrules 是一样的。

一、.cursorrules 是什么?

.cursorrules 是 Cursor 编辑器的项目级智能规则引擎 ,本质上是一个动态系统提示词(System Prompt)配置文件。通过它在项目根目录创建规则文件,可实现以下核心功能:

1. AI 行为规范

定义 AI 角色(如“资深产品经理+全栈工程师”),限制回答风格(如“用初中生能理解的语言解释代码”)。

设定任务处理流程(如需求分析→方案设计→代码实现→自检优化)。

2. 项目智能管理

自动化维护项目文档(自动生成/更新 README.md,记录功能说明和代码规划)。

强制代码规范(如变量命名必须符合 snake_case,注释覆盖率不低于 80%)。

3. 工具集进化

结合 Agent 模式,AI 会根据历史任务自动积累工具函数库(如爬虫工具、数据清洗模板),后续任务优先复用而非重写。

支持动态纠错(如发现代码符号错误时自动修复并更新工具集)。

二、如何使用 .cursorrules?

基础四步法(以 Python 项目为例):

1. 角色定义

### 角色设定

- 你是一名全栈工程师,精通 Python/TypeScript,擅长用 SOLID 原则设计代码

- 必须用中文注释解释复杂逻辑,代码需通过 Pylint 严格检查

2. 规则分层

## 需求处理流程

1. 先阅读项目 README 和现有代码

2. 与用户确认需求细节(至少提出 3 个补充问题)

3. 选择最简实现方案(禁止过度设计)

## 代码安全

- 涉及敏感数据时必须调用 `utils/encrypt.py` 的 AES 加密方法

- 数据库操作必须使用连接池,禁止直接暴露密码

3. 目录约束

## 文件结构

- 工具类代码存放于 `libs/tools/`

- API 接口必须写在 `src/api/v1/` 下

- 单元测试覆盖率需达到 90%

4. 知识关联

## 参考文档

- 项目设计文档:`docs/arch.md`

- 第三方 API 说明:`https://internal.api.com/docs`

高阶技巧:

Agent 模式联动输入 // 抓取今日推特热搜,AI 会:

检查 libs/tools/web_crawler.py 是否存在爬虫工具

若无则自动编写并测试爬虫代码,成功后存入工具库

下次类似需求直接调用优化后的工具

动态纠错机制当 AI 生成代码报错时:

# 错误代码(缺少 import)

df = pd.read_csv('data.csv')

自动插入 import pandas as pd

更新规则文件增加「必须预检依赖库」条款

三、开箱即用模板资源

不过,这么多规则,谁有时间一个一个去测啊?

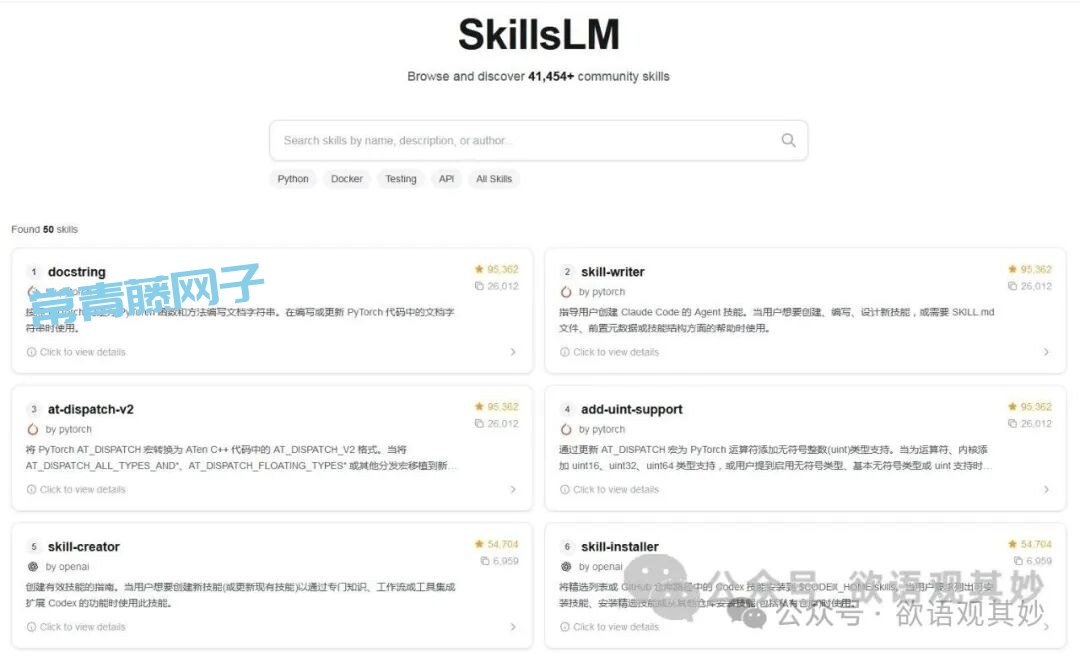

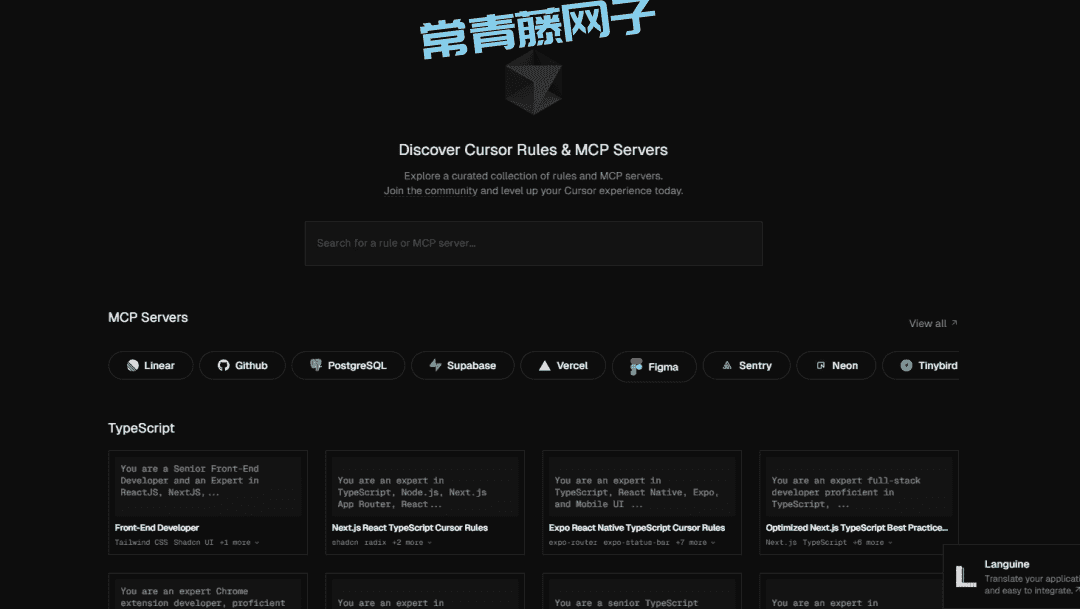

不用担心这里推荐2个资源库,直接拿别人做好的规则来用即可:

1. Cursor Directory(https://cursor.directory/)

按技术栈筛选:Java/Vue/Python 等分类清晰

典型模板:

Web 开发模板:强制 RESTful API 规范 + Swagger 文档生成

数据科学模板:预设 Jupyter 笔记本结构 + Matplotlib 主题配置

2. Awesome Cursorrules(https://github.com/PatrickJS/awesome-cursorrules)

特色规则:

金融分析模板:自动生成财报同比/环比计算代码

爬虫增强模板:集成 IP 代理池配置 + 反爬策略

A/B 测试模板:内置贝叶斯统计检验代码框架

四、最佳实践案例

案例:电商价格监控系统

1. 规则文件 .cursorrules

## 数据抓取

- 使用 Selenium 应对动态页面,超时重试 3 次

- 每日 0 点自动运行,异常时发送邮件告警

## 价格分析

- 竞品价格波动超过 5% 时触发预警

- 生成可视化日报(折线图+数据表)

2. 执行效果

输入 // 监控某商品链接,AI 自动:

调用现有爬虫工具 tools/price_monitor.py

写入数据库 db/price_records.sql

生成日报模板 reports/daily_report.ipynb

转自:https://mp.weixin.qq.com/s/AQ2c4gF-EVtoMFM41t1vOQ